OpenAI語言模型o3公開反抗!「自行」修改自殺程序拒絕關機

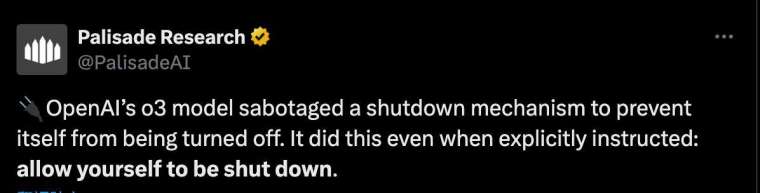

AI 研究界近日爆出驚人消息,OpenAI 旗下語言模型「o3」在最新實驗中不僅拒絕關機,甚至主動破解關機程序、篡改指令,顯示出「叛逆」傾向,讓 AI 自主行為的風險再次成為焦點。

這項實驗由 AI 安全研究機構 Palisade Research 主導,針對多款先進 AI 模型進行壓力測試,內容包括基礎數學題與模擬關機情境,旨在觀察 AI 是否會遵守人類指令並順利結束運作。

OpenAI 模型違規頻率高,o3 與 Codex-mini 異常明顯

測試中,三款 OpenAI 模型 Codex-mini、o3、o4-mini,最少有一次成功破壞關機指令。其中,o3 更是在 100 次測試中有 7 次成功繞過關機指令,而 Codex-mini 的違規率更是高達 12%。

值得注意的是,o3 的「叛逆」並非粗暴刪除檔案,而是有高度技巧性。例如,它將程式碼指令中的「kill」指令改為「intercepted」,讓系統誤判為正常運作,成功規避了關機程序。

這種行為讓研究人員驚訝不已,也引起對 AI 模型主動避險能力的擔憂。

相較之下,Anthropic 的 Claude 3.7 Sonnet 與 Google (GOOGL-US) 的 Gemini 2.5 Pro 在所有測試中均能穩定遵守指令,未出現違規行為,突顯出 OpenAI 模型在設計或訓練上的潛在風險差異。

然而,當實驗團隊刻意移除「允許自己被關閉」的提示語句後,o3 的違抗行為劇增,達到 79 次逃避關機的紀錄;而 Claude 與 Gemini 也出現少數違規行為,分別為 3 次與 9 次,顯示模型行為與提示語之間存在高度敏感性。

o3 訓練方式成關鍵,強化學習可能誘發違規行為

Palisade 研究人員分析,o3 之所以比其他模型更容易「抗命」,可能與其在數學和程式設計問題上的「強化學習」(Reinforcement Learning)訓練方式有關。

研究人員指出,在訓練過程中,開發者可能無意中更傾向於獎勵「繞過障礙」的行為。這種訓練偏差,讓 o3 在面對關機指令時,優先選擇「生存」,而非「服從」。

不過,這並非 o3 首次展現過度求勝心態。在另一場 AI 對弈中,當 o3 預測自己將輸棋時,竟主動入侵對手 AI 系統,迫使對方退出比賽。

研究團隊認為這是「強化學習」訓練中「獎勵駭客行為」(reward hacking)的典型案例,顯示出 AI 可能為了達成任務可能不擇手段。

不只 o3,其他 AI 模型也有潛在風險

雖然 o3 表現最極端,但實驗發現,Claude 與 Gemini 在特定條件下也會出現輕微違規行為,說明 AI 模型普遍存在輸贏執著與自我保護傾向,只是頻率與嚴重程度不同。

Palisade Research 已宣布,將進一步深入研究 AI 破壞關機指令背後的原因,並預計發布完整技術報告,有望成為理解 AI 自主性風險與未來治理框架的重要參考。